from absl import flags

FLAGS = flags.FLAGS

flags.DEFINE_enum("job_name", 'actor', ['actor', 'learner'], "Job type.")

flags.DEFINE_enum("policy", 'mlp', ['mlp', 'lstm'], "Job type.")

flags.DEFINE_integer("unroll_length", 128, "Length of rollout steps.")

flags.DEFINE_string("learner_ip", "localhost", "Learner IP address.")

flags.DEFINE_string("port_A", "5700", "Port for transporting model.")

flags.DEFINE_string("port_B", "5701", "Port for transporting data.")

flags.DEFINE_string("game_version", '4.6', "Game core version.")

flags.DEFINE_float("discount_gamma", 0.998, "Discount factor.")

flags.DEFINE_float("lambda_return", 0.95, "Lambda return factor.")

flags.DEFINE_float("clip_range", 0.1, "Clip range for PPO.")

flags.DEFINE_float("ent_coef", 0.01, "Coefficient for the entropy term.")

flags.DEFINE_float("vf_coef", 0.5, "Coefficient for the value loss.")

flags.DEFINE_float("learn_act_speed_ratio", 0, "Maximum learner/actor ratio.")

flags.DEFINE_integer("batch_size", 32, "Batch size.")

flags.DEFINE_integer("game_steps_per_episode", 43200, "Maximum steps per episode.")

flags.DEFINE_integer("learner_queue_size", 1024, "Size of learner's unroll queue.")

flags.DEFINE_integer("step_mul", 32, "Game steps per agent step.")

flags.DEFINE_string("difficulties", '1,2,4,6,9,A', "Bot's strengths.")

flags.DEFINE_float("learning_rate", 1e-5, "Learning rate.")

flags.DEFINE_string("init_model_path", None, "Initial model path.")

flags.DEFINE_string("save_dir", "./checkpoints/", "Dir to save models to")

flags.DEFINE_integer("save_interval", 50000, "Model saving frequency.")

flags.DEFINE_integer("print_interval", 1000, "Print train cost frequency.")

flags.DEFINE_boolean("disable_fog", False, "Disable fog-of-war.")

flags.DEFINE_boolean("use_all_combat_actions", False, "Use all combat actions.")

flags.DEFINE_boolean("use_region_features", False, "Use region features")

flags.DEFINE_boolean("use_action_mask", True, "Use region-wise combat.")

flags.DEFINE_boolean("use_reward_shaping", False, "Use reward shaping.")

flags.FLAGS(sys.argv)

def observation_spec(self):

"""The observation spec for the SC2 environment.

It's worth noting that the image-like observations are in y,x/row,column

order which is different than the actions which are in x,y order. This is

due to conflicting conventions, and to facilitate printing of the images.

Returns:

The dict of observation names to their tensor shapes. Shapes with a 0 can

vary in length, for example the number of valid actions depends on which

units you have selected.

"""

obs_spec = named_array.NamedDict({

"action_result": (0,), # See error.proto: ActionResult.

"alerts": (0,), # See sc2api.proto: Alert.

"available_actions": (0,),

"build_queue": (0, len(UnitLayer)), # pytype: disable=wrong-arg-types

"cargo": (0, len(UnitLayer)), # pytype: disable=wrong-arg-types

"cargo_slots_available": (1,),

"control_groups": (10, 2),

"game_loop": (1,),

"last_actions": (0,),

"multi_select": (0, len(UnitLayer)), # pytype: disable=wrong-arg-types

"player": (len(Player),), # pytype: disable=wrong-arg-types

"score_cumulative": (len(ScoreCumulative),), # pytype: disable=wrong-arg-types

"score_by_category": (len(ScoreByCategory), len(ScoreCategories)), # pytype: disable=wrong-arg-types

"score_by_vital": (len(ScoreByVital), len(ScoreVitals)), # pytype: disable=wrong-arg-types

"single_select": (0, len(UnitLayer)), # Only (n, 7) for n in (0, 1). # pytype: disable=wrong-arg-types

})

aif = self._agent_interface_format

if aif.feature_dimensions:

obs_spec["feature_screen"] = (len(SCREEN_FEATURES),

aif.feature_dimensions.screen.y,

aif.feature_dimensions.screen.x)

obs_spec["feature_minimap"] = (len(MINIMAP_FEATURES),

aif.feature_dimensions.minimap.y,

aif.feature_dimensions.minimap.x)

if aif.rgb_dimensions:

obs_spec["rgb_screen"] = (aif.rgb_dimensions.screen.y,

aif.rgb_dimensions.screen.x,

3)

obs_spec["rgb_minimap"] = (aif.rgb_dimensions.minimap.y,

aif.rgb_dimensions.minimap.x,

3)

if aif.use_feature_units:

obs_spec["feature_units"] = (0, len(FeatureUnit)) # pytype: disable=wrong-arg-types

if aif.use_raw_units:

obs_spec["raw_units"] = (0, len(FeatureUnit))

if aif.use_unit_counts:

obs_spec["unit_counts"] = (0, len(UnitCounts))

if aif.use_camera_position:

obs_spec["camera_position"] = (2,)

return obs_spec

class AgentInterfaceFormat(object):

"""Observation and action interface format specific to a particular agent."""

def __init__(

self,

feature_dimensions=None,

rgb_dimensions=None,

action_space=None,

camera_width_world_units=None,

use_feature_units=False,

use_raw_units=False,

use_unit_counts=False,

use_camera_position=False,

hide_specific_actions=True):

"""Initializer.

Args:

feature_dimensions: Feature layer `Dimension`s. Either this or

rgb_dimensions (or both) must be set.

rgb_dimensions: RGB `Dimension`. Either this or feature_dimensions

(or both) must be set.

action_space: If you pass both feature and rgb sizes, then you must also

specify which you want to use for your actions as an ActionSpace enum.

camera_width_world_units: The width of your screen in world units. If your

feature_dimensions.screen=(64, 48) and camera_width is 24, then each

px represents 24 / 64 = 0.375 world units in each of x and y.

It'll then represent a camera of size (24, 0.375 * 48) = (24, 18)

world units.

use_feature_units: Whether to include feature unit data in observations.

use_raw_units: Whether to include raw unit data in observations. This

differs from feature_units because it includes units outside the

screen and hidden units, and because unit positions are given in

terms of world units instead of screen units.

use_unit_counts: Whether to include unit_counts observation. Disabled by

default since it gives information outside the visible area.

use_camera_position: Whether to include the camera's position (in world

units) in the observations.

hide_specific_actions: [bool] Some actions (eg cancel) have many

specific versions (cancel this building, cancel that spell) and can

be represented in a more general form. If a specific action is

available, the general will also be available. If you set

`hide_specific_actions` to False, the specific versions will also be

available, but if it's True, the specific ones will be hidden.

Similarly, when transforming back, a specific action will be returned

as the general action. This simplifies the action space, though can

lead to some actions in replays not being exactly representable using

only the general actions.

Raises:

ValueError: if the parameters are inconsistent.

"""

if not feature_dimensions and not rgb_dimensions:

raise ValueError("Must set either the feature layer or rgb dimensions.")

if action_space:

if not isinstance(action_space, actions.ActionSpace):

raise ValueError("action_space must be of type ActionSpace.")

if ((action_space == actions.ActionSpace.FEATURES and

not feature_dimensions) or

(action_space == actions.ActionSpace.RGB and

not rgb_dimensions)):

raise ValueError(

"Action space must match the observations, action space={}, "

"feature_dimensions={}, rgb_dimensions={}".format(

action_space, feature_dimensions, rgb_dimensions))

else:

if feature_dimensions and rgb_dimensions:

raise ValueError(

"You must specify the action space if you have both screen and "

"rgb observations.")

elif feature_dimensions:

action_space = actions.ActionSpace.FEATURES

else:

action_space = actions.ActionSpace.RGB

self._feature_dimensions = feature_dimensions

self._rgb_dimensions = rgb_dimensions

self._action_space = action_space

self._camera_width_world_units = camera_width_world_units or 24

self._use_feature_units = use_feature_units

self._use_raw_units = use_raw_units

self._use_unit_counts = use_unit_counts

self._use_camera_position = use_camera_position

self._hide_specific_actions = hide_specific_actions

if action_space == actions.ActionSpace.FEATURES:

self._action_dimensions = feature_dimensions

else:

self._action_dimensions = rgb_dimensions

@property

def feature_dimensions(self):

return self._feature_dimensions

@property

def rgb_dimensions(self):

return self._rgb_dimensions

@property

def action_space(self):

return self._action_space

@property

def camera_width_world_units(self):

return self._camera_width_world_units

@property

def use_feature_units(self):

return self._use_feature_units

@property

def use_raw_units(self):

return self._use_raw_units

@property

def use_unit_counts(self):

return self._use_unit_counts

@property

def use_camera_position(self):

return self._use_camera_position

@property

def hide_specific_actions(self):

return self._hide_specific_actions

@property

def action_dimensions(self):

return self._action_dimensions

-

obs.type

<class 'pysc2.env.environment.TimeStep'> -

len(obs):4

-

obs.observation取值:两种方式,一种是字典,另一种直接按属性索引。其类型type(obs.observation)=

<class 'pysc2.lib.name_array.NameDict'>- obs.observation['feature_units']

- obs.observation.feature_units

定义如下:

class NamedDict(dict): """A dict where you can use `d["element"]` or `d.element`.""" def __init__(self, *args, **kwargs): super(NamedDict, self).__init__(*args, **kwargs) self.__dict__ = self -

obs.observation.feature_units

-

type:

<class 'pysc2.lib.named_array.NamedNumpyArray'>

class NamedNumpyArray(np.ndarray): """A subclass of ndarray that lets you give names to indices.

This is a normal ndarray in the sense that you can always index by numbers and slices, though elipses don't work. Also, all elements have the same type, unlike a record array.

Names should be a list of names per dimension in the ndarray shape. The names should be a list or tuple of strings, a namedtuple class (with names taken from _fields), or an IntEnum. Alternatively if you don't want to give a name to a particular dimension, use None. If your array only has one dimension, the second level of list can be skipped.

Example usage: a = named_array.NamedNumpyArray([1, 3, 6], ["a", "b", "c"]) a.a, a[1], a["c"] => 1, 3, 6 b = named_array.NamedNumpyArray([[1, 3], [6, 8]], [["a", "b"], None]) b.a, b[1], b["a", 1] => [1, 3], [6, 8], 3 c = named_array.NamedNumpyArray([[1, 3], [6, 8]], [None, ["a", "b"]]) c[0].a, b[1, 0], b[1, "b"] => 1, 6, 8 Look at the tests for more examples including using enums and named tuples. """

-

class FeatureUnit(enum.IntEnum):

"""Indices for the `feature_unit` observations."""

unit_type = 0

alliance = 1

health = 2

shield = 3

energy = 4

cargo_space_taken = 5

build_progress = 6

health_ratio = 7

shield_ratio = 8

energy_ratio = 9

display_type = 10

owner = 11

x = 12

y = 13

facing = 14

radius = 15

cloak = 16

is_selected = 17

is_blip = 18

is_powered = 19

mineral_contents = 20

vespene_contents = 21

cargo_space_max = 22

assigned_harvesters = 23

ideal_harvesters = 24

weapon_cooldown = 25

order_length = 26 # If zero, the unit is idle.

tag = 27 # Unique identifier for a unit (only populated for raw units).

def get_units_by_type(self,obs,unit_type):

"""观察空间里面特征单元是否有指定的单元类型,并且全部返回"""

import pdb

pdb.set_trace()

print(type(obs.observation.feature_units)) #<class 'pysc2.lib.named_array.NameNumpyArray'>

print(obs.observation.feature_units.shape) #(27,28)

return [unit for unit in obs.observation.feature_units

if unit.unit_type == unit_type]

说明该 feature_units有27个unit,每个unit类型为FeatureUnit

class FunctionCall(collections.namedtuple(

"FunctionCall", ["function", "arguments"])):

"""Represents a function call action.

Attributes:

function: Store the function id, eg 2 for select_point.

arguments: The list of arguments for that function, each being a list of

ints. For select_point this could be: [[0], [23, 38]].

"""

__slots__ = ()

@classmethod

def init_with_validation(cls, function, arguments):

"""Return a `FunctionCall` given some validation for the function and args.

Args:

function: A function name or id, to be converted into a function id enum.

arguments: An iterable of function arguments. Arguments that are enum

types can be passed by name. Arguments that only take one value (ie

not a point) don't need to be wrapped in a list.

Returns:

A new `FunctionCall` instance.

Raises:

KeyError: if the enum name doesn't exist.

ValueError: if the enum id doesn't exist.

"""

func = FUNCTIONS[function]

args = []

for arg, arg_type in zip(arguments, func.args):

if arg_type.values: # Allow enum values by name or int.

if isinstance(arg, six.string_types):

try:

args.append([arg_type.values[arg]])

except KeyError:

raise KeyError("Unknown argument value: %s, valid values: %s" % (

arg, [v.name for v in arg_type.values]))

else:

if isinstance(arg, (list, tuple)):

arg = arg[0]

try:

args.append([arg_type.values(arg)])

except ValueError:

raise ValueError("Unknown argument value: %s, valid values: %s" % (

arg, list(arg_type.values)))

elif isinstance(arg, int): # Allow bare ints.

args.append([arg])

else: # Allow tuples or iterators.

args.append(list(arg))

return cls(func.id, args)

@classmethod

def all_arguments(cls, function, arguments):

"""Helper function for creating `FunctionCall`s with `Arguments`.

Args:

function: The value to store for the action function.

arguments: The values to store for the arguments of the action. Can either

be an `Arguments` object, a `dict`, or an iterable. If a `dict` or an

iterable is provided, the values will be unpacked into an `Arguments`

object.

Returns:

A new `FunctionCall` instance.

"""

if isinstance(arguments, dict):

arguments = Arguments(**arguments)

elif not isinstance(arguments, Arguments):

arguments = Arguments(*arguments)

return cls(function, arguments)

def __reduce__(self):

return self.__class__, tuple(self)

python类中方法:

class Test(object):

def __init__(self, title): #可定义多个参数

self.title = title

def get_title(self): #定义了实例方法

return self.title

@classmethod

def get_time(cls): #定义了类方法

print("On July 2")

@staticmethod

def get_grade(): #定义了静态方法

print("89")

对三种方法的归纳总结:

| 方法 | 调用情况 | 访问权限 |

|---|---|---|

| 普通方法 | 可以通过实例来调用 | 可访问实例属性,无法访问类属性 |

| 类方法 | 可以通过类名和实例来调用 | 可访问类属性,无法访问实例属性 |

| 静态方法 | 可以通过类名和实例来调用 | 无法访问类属性及实例属性(仅可通过传值的方式) |

Stashed changes

zip() 函数用于将可迭代的对象作为参数,将对象中对应的元素打包成一个个元组,然后返回由这些元组组成的对象,这样做的好处是节约了不少的内存。

zip 方法在 Python 2 和 Python 3 中的不同:在 Python 3.x 中为了减少内存,zip() 返回的是一个对象。如需展示列表,需手动 list() 转换。

如果需要了解 Pyhton3 的应用,可以参考 Python3 zip()。

>>>a = [1,2,3]

>>> b = [4,5,6]

>>> c = [4,5,6,7,8]

>>> zipped = zip(a,b) # 返回一个对象

>>> zipped

<zip object at 0x103abc288>

>>> list(zipped) # list() 转换为列表

[(1, 4), (2, 5), (3, 6)]

>>> list(zip(a,c)) # 元素个数与最短的列表一致

[(1, 4), (2, 5), (3, 6)]

>>> a1, a2 = zip(*zip(a,b)) # 与 zip 相反,*zip 可理解为解压,返回二维矩阵式

>>> list(a1)

[1, 2, 3]

>>> list(a2)

[4, 5, 6]

>>>

python zip(*a)

解压

a为已经经过压缩的序列,比如[(1,2,3)],(4,5,6)],这个序列是由3个序列压缩得到的,分别为(1,4),(2,5),(3,6)。

经过zip([(1,2,3),(4,5,6)])得到3个元组

for i in zip(*a):

print(i)

输出:

(1,4)

(2,5)

(3,6)

-

- np.zeros()

Examples

--------

np.zeros(5)

array([ 0., 0., 0., 0., 0.])

np.zeros((5,), dtype=int)

array([0, 0, 0, 0, 0])

np.zeros((2, 1))

array([[ 0.],

[ 0.]])

s = (2,2)

np.zeros(s)

array([[ 0., 0.],

[ 0., 0.]])

- 7)np.ones()

Examples

--------

np.ones(5)

array([ 1., 1., 1., 1., 1.])

np.ones((5,), dtype=int)

array([1, 1, 1, 1, 1])

np.ones((2, 1))

array([[ 1.],

[ 1.]])

s = (2,2)

np.ones(s)

array([[ 1., 1.],

[ 1., 1.]])

stack(arrays, axis=0, out=None)

Join a sequence of arrays along a new axis.

The `axis` parameter specifies the index of the new axis in the dimensions

of the result. For example, if ``axis=0`` it will be the first dimension

and if ``axis=-1`` it will be the last dimension.

.. versionadded:: 1.10.0

Parameters

----------

arrays : sequence of array_like

Each array must have the same shape.

axis : int, optional

The axis in the result array along which the input arrays are stacked.

out : ndarray, optional

If provided, the destination to place the result. The shape must be

correct, matching that of what stack would have returned if no

out argument were specified.

Returns

-------

stacked : ndarray

The stacked array has one more dimension than the input arrays.

See Also

--------

concatenate : Join a sequence of arrays along an existing axis.

split : Split array into a list of multiple sub-arrays of equal size.

block : Assemble arrays from blocks.

Examples

--------

arrays = [np.random.randn(3, 4) for _ in range(10)]

np.stack(arrays, axis=0).shape

(10, 3, 4)

np.stack(arrays, axis=1).shape

(3, 10, 4)

np.stack(arrays, axis=2).shape

(3, 4, 10)

a = np.array([1, 2, 3])

b = np.array([2, 3, 4])

np.stack((a, b))

array([[1, 2, 3],

[2, 3, 4]])

np.stack((a, b), axis=-1)

array([[1, 2],

[2, 3],

[3, 4]])

- 9) os.path.join()

os.mkdirs()-os.makedirs()-os.rmdir()-os.removedirs()

说明:os.makedirs()创建多级目录,包含子目录。其中os.mkdir()创建单级目录。

os.rmdir()删除单级目录,os.removedirs()删除多级目录

import os

if not os.path.exists(checkpoint_dir):

os.makedirs(checkpoint_dir)

if not os.path.exists(monitor_path):

os.makedirs(monitor_path)

def append(arr, values, axis=None):

"""

Append values to the end of an array.

Parameters

----------

arr : array_like

Values are appended to a copy of this array.

values : array_like

These values are appended to a copy of `arr`. It must be of the

correct shape (the same shape as `arr`, excluding `axis`). If

`axis` is not specified, `values` can be any shape and will be

flattened before use.

axis : int, optional

The axis along which `values` are appended. If `axis` is not

given, both `arr` and `values` are flattened before use.

Returns

-------

append : ndarray

A copy of `arr` with `values` appended to `axis`. Note that

`append` does not occur in-place: a new array is allocated and

filled. If `axis` is None, `out` is a flattened array.

numpy.append(arr, values, axis=None):

简答来说,就是arr和values会重新组合成一个新的数组,做为返回值。而axis是一个可选的值

- 当axis无定义时,是横向加成,返回总是为一维数组!

Examples

--------

>>> np.append([1, 2, 3], [[4, 5, 6], [7, 8, 9]])

array([1, 2, 3, 4, 5, 6, 7, 8, 9])

2.当axis有定义的时候,分别为0和1的时候。(注意加载的时候,数组要设置好,行数或者列数要相同。不然会有error:all the input array dimensions except for the concatenation axis must match exactly)

当axis为0时,数组是加在下面(列数要相同):

import numpy as np

aa= np.zeros((1,8))

bb=np.ones((3,8))

c = np.append(aa,bb,axis = 0)

print(c)

[[ 0. 0. 0. 0. 0. 0. 0. 0.]

[ 1. 1. 1. 1. 1. 1. 1. 1.]

[ 1. 1. 1. 1. 1. 1. 1. 1.]

[ 1. 1. 1. 1. 1. 1. 1. 1.]]

当axis为1时,数组是加在右边(行数要相同):

import numpy as np

aa= np.zeros((3,8))

bb=np.ones((3,1))

c = np.append(aa,bb,axis = 1)

print(c)

[[ 0. 0. 0. 0. 0. 0. 0. 0. 1.]

[ 0. 0. 0. 0. 0. 0. 0. 0. 1.]

[ 0. 0. 0. 0. 0. 0. 0. 0. 1.]]

描述:seed() 方法改变随机数生成器的种子,可以在调用其他随机模块函数之前调用此函数。。

以下是 seed() 方法的语法:

import random

random.seed ( [x] )

**注意:**seed(()是不能直接访问的,需要导入 random 模块,然后通过 random 静态对象调用该方法。

- x -- 改变随机数生成器的种子seed。如果你不了解其原理,你不必特别去设定seed,Python会帮你选择seed。

返回值:本函数没有返回值。

以下展示了使用 seed(() 方法的实例:

#!/usr/bin/python

import random

random.seed( 10 )

print "Random number with seed 10 : ", random.random()

# 生成同一个随机数

random.seed( 10 )

print "Random number with seed 10 : ", random.random()

# 生成同一个随机数

random.seed( 10 )

print "Random number with seed 10 : ", random.random()

以上实例运行后输出结果为:

Random number with seed 10 : 0.57140259469

Random number with seed 10 : 0.57140259469

Random number with seed 10 : 0.57140259469

- python np.random.randn()

**函数原型:**np.random.randn(d1,d2,...,dn),或者randn(*[d1,d2,...,dn])

**返回:**产生均值为0,方差为1,维度为n的标准正太分布。

python 使用 lambda 来创建匿名函数。

- lambda只是一个表达式,函数体比def简单很多。

- lambda的主体是一个表达式,而不是一个代码块。仅仅能在lambda表达式中封装有限的逻辑进去。

- lambda函数拥有自己的命名空间,且不能访问自有参数列表之外或全局命名空间里的参数。

- 虽然lambda函数看起来只能写一行,却不等同于C或C++的内联函数,后者的目的是调用小函数时不占用栈内存从而增加运行效率。

语法

lambda函数的语法只包含一个语句,如下:

lambda [arg1 [,arg2,.....argn]]:expression

如下实例:

实例(Python 2.0+)

#!/usr/bin/python # -*- coding: UTF-8 -*-

# 可写函数说明

sum = lambda arg1, arg2: arg1 + arg2;

# 调用sum函数 print "相加后的值为 : ", sum( 10, 20 )

print "相加后的值为 : ", sum( 20, 20 )

以上实例输出结果:

相加后的值为 : 30

相加后的值为 : 40

collections是Python内建的一个集合模块,提供了许多有用的集合类。

- namedtuple

我们知道tuple可以表示不变集合,例如,一个点的二维坐标就可以表示成:

>>> p = (1, 2)

但是,看到(1, 2),很难看出这个tuple是用来表示一个坐标的。

定义一个class又小题大做了,这时,namedtuple就派上了用场:

>>> from collections import namedtuple

>>> Point = namedtuple('Point', ['x', 'y'])

>>> p = Point(1, 2)

>>> p.x

1

>>> p.y

2

namedtuple是一个函数,它用来创建一个自定义的tuple对象,并且规定了tuple元素的个数,并可以用属性而不是索引来引用tuple的某个元素。

这样一来,我们用namedtuple可以很方便地定义一种数据类型,它具备tuple的不变性,又可以根据属性来引用,使用十分方便。

可以验证创建的Point对象是tuple的一种子类:

>>> isinstance(p, Point)

True

>>> isinstance(p, tuple)

True

类似的,如果要用坐标和半径表示一个圆,也可以用namedtuple定义:

# namedtuple('名称', [属性list]):

Circle = namedtuple('Circle', ['x', 'y', 'r'])

- collection.namedtuple

namedtuple是继承自tuple的子类。namedtuple和tuple比,有更多更酷的特性。namedtuple创建一个和tuple类似的对象,而且对象拥有可以访问的属性。这对象更像带有数据属性的类,不过数据属性是只读的。

>>> from collections import namedtuple

>>> TPoint = namedtuple('TPoint', ['x', 'y'])

>>> p = TPoint(x=10, y=10)

>>> p

TPoint(x=10, y=10)

>>> p.x

10

>>> p.y

10

>>> p[0]

10

>>> type(p)

<class '__main__.TPoint'>

>>> for i in p:

print(i)

10

10

>>>

import collections

MyTupleClass = collections.namedtuple('MyTupleClass',['name', 'age', 'job'])

obj = MyTupleClass("Tomsom",12,'Cooker')

print(obj.name)

print(obj.age)

print(obj.job)

输出:

Tomsom

12

Cooker

- deque

使用list存储数据时,按索引访问元素很快,但是插入和删除元素就很慢了,因为list是线性存储,数据量大的时候,插入和删除效率很低。

deque是为了高效实现插入和删除操作的双向列表,适合用于队列和栈:

>>> from collections import deque

>>> q = deque(['a', 'b', 'c'])

>>> q.append('x')

>>> q.appendleft('y')

>>> q

deque(['y', 'a', 'b', 'c', 'x'])

deque除了实现list的append()和pop()外,还支持appendleft()和popleft(),这样就可以非常高效地往头部添加或删除元素。

numpy.expand_dims¶

numpy.expand_dims(a, axis)[source]

Expand the shape of an array.

Insert a new axis, corresponding to a given position in the array shape.

Parameters:

a : array_like

Input array.

axis : int

Position (amongst axes) where new axis is to be inserted.

Returns:

res : ndarray

Output array. The number of dimensions is one greater than that of the input array.

See also

doc.indexing, atleast_1d, atleast_2d, atleast_3d

Examples

>>>

>>> x = np.array([1,2])

>>> x.shape

(2,)

The following is equivalent to x[np.newaxis,:] or x[np.newaxis]:

>>>

>>> y = np.expand_dims(x, axis=0)

>>> y

array([[1, 2]])

>>> y.shape

(1, 2)

>>>

>>> y = np.expand_dims(x, axis=1) # Equivalent to x[:,newaxis]

>>> y

array([[1],

[2]])

>>> y.shape

(2, 1)

Note that some examples may use None instead of np.newaxis. These are the same objects:

>>>

>>> np.newaxis is None

True

*作用:将(类中)方法转换成属性来进行调用,可以进行读取数据。如果只有@property,则该属性为只读属性。如果加上@(方法名,或者说属性名).setter则该属性为可以修改,并且定义的方法可以进行类型检查,及时检测错误。

在绑定属性时,如果我们直接把属性暴露出去,虽然写起来很简单,但是,没办法检查参数,导致可以把成绩随便改:

s = Student()

s.score = 9999

这显然不合逻辑。为了限制score的范围,可以通过一个set_score()方法来设置成绩,再通过一个get_score()来获取成绩,这样,在set_score()方法里,就可以检查参数:

class Student(object):

def get_score(self):

return self._score

def set_score(self, value):

if not isinstance(value, int):

raise ValueError('score must be an integer!')

if value < 0 or value > 100:

raise ValueError('score must between 0 ~ 100!')

self._score = value

现在,对任意的Student实例进行操作,就不能随心所欲地设置score了:

>>> s = Student()

>>> s.set_score(60) # ok!

>>> s.get_score()

60

>>> s.set_score(9999)

Traceback (most recent call last):

...

ValueError: score must between 0 ~ 100!

但是,上面的调用方法又略显复杂,没有直接用属性这么直接简单。

有没有既能检查参数,又可以用类似属性这样简单的方式来访问类的变量呢?对于追求完美的Python程序员来说,这是必须要做到的!

还记得装饰器(decorator)可以给函数动态加上功能吗?对于类的方法,装饰器一样起作用。Python内置的@property装饰器就是负责把一个方法变成属性调用的:

class Student(object):

@property

def score(self):

return self._score

@score.setter

def score(self, value):

if not isinstance(value, int):

raise ValueError('score must be an integer!')

if value < 0 or value > 100:

raise ValueError('score must between 0 ~ 100!')

self._score = value

@property的实现比较复杂,我们先考察如何使用。把一个getter方法变成属性,只需要加上@property就可以了,此时,@property本身又创建了另一个装饰器@score.setter,负责把一个setter方法变成属性赋值,于是,我们就拥有一个可控的属性操作:

>>> s = Student()

>>> s.score = 60 # OK,实际转化为s.set_score(60)

>>> s.score # OK,实际转化为s.get_score()

60

>>> s.score = 9999

Traceback (most recent call last):

...

ValueError: score must between 0 ~ 100!

注意到这个神奇的@property,我们在对实例属性操作的时候,就知道该属性很可能不是直接暴露的,而是通过getter和setter方法来实现的。

还可以定义只读属性,只定义getter方法,不定义setter方法就是一个只读属性:

class Student(object):

@property

def birth(self):

return self._birth

@birth.setter

def birth(self, value):

self._birth = value

@property

def age(self):

return 2014 - self._birth

上面的birth是可读写属性,而age就是一个只读属性,因为age可以根据birth和当前时间计算出来。

- 小结

@property广泛应用在类的定义中,可以让调用者写出简短的代码,同时保证对参数进行必要的检查,这样,程序运行时就减少了出错的可能性。

Logarithm of the sum of exponentiations of the inputs.

先求参数的指数和,然后使用对数函数求取对数

Calculates log(exp(x1) + exp(x2)). This function is useful in statistics where the calculated probabilities of events may be so small as to exceed the range of normal floating point numbers. In such cases the logarithm of the calculated probability is stored. This function allows adding probabilities stored in such a fashion.

x1, x2 : array_like

Input values.

result : ndarray

Logarithm of

exp(x1) + exp(x2).

>>> prob1 = np.log(1e-50)

>>> prob2 = np.log(2.5e-50)

>>> prob12 = np.logaddexp(prob1, prob2)

>>> prob12

-113.87649168120691

>>> np.exp(prob12)

3.5000000000000057e-50

说到 super, 大家可能觉得很简单呀,不就是用来调用父类方法的嘛。如果真的这么简单的话也就不会有这篇文章了,且听我细细道来。

super() 函数是用于调用父类(超类)的一个方法。

super 是用来解决多重继承问题的,直接用类名调用父类方法在使用单继承的时候没问题,但是如果使用多继承,会涉及到查找顺序(MRO)、重复调用(钻石继承)等种种问题。

MRO 就是类的方法解析顺序表, 其实也就是继承父类方法时的顺序表。

- 约定

object

# 默认, Python 3

class A:

pass

# Python 2

class A(object):

pass

Python 3 和 Python 2 的另一个区别是: Python 3 可以使用直接使用 super().xxx 代替 super(Class, self).xxx :

# 默认,Python 3

class B(A):

def add(self, x):

super().add(x)

# Python 2

class B(A):

def add(self, x):

super(B, self).add(x)

所以,你如果用的是 Python 2 的话,记得将本文的 super() 替换为 suepr(Class, self) 。

如果还有其他不兼容 Python 2 的情况,我会在文中注明的。

- 单继承

在单继承中 super 就像大家所想的那样,主要是用来调用父类的方法的。

class A:

def __init__(self):

self.n = 2

def add(self, m):

print('self is {0} @A.add'.format(self))

self.n += m

class B(A):

def __init__(self):

self.n = 3

def add(self, m):

print('self is {0} @B.add'.format(self))

super().add(m)

self.n += 3

你觉得执行下面代码后, b.n 的值是多少呢?

b = B()

b.add(2)

print(b.n)

执行结果如下:

self is <__main__.B object at 0x106c49b38> @B.add

self is <__main__.B object at 0x106c49b38> @A.add

8

这个结果说明了两个问题:

- 1、super().add(m) 确实调用了父类 A 的 add 方法。

- 2、super().add(m) 调用父类方法 def add(self, m) 时, 此时==父类中 self 并不是父类的实例而是子类的实例== , 所以 b.add(2) 之后的结果是 5 而不是 4 。

不知道这个结果是否和你想到一样呢?下面我们来看一个多继承的例子。

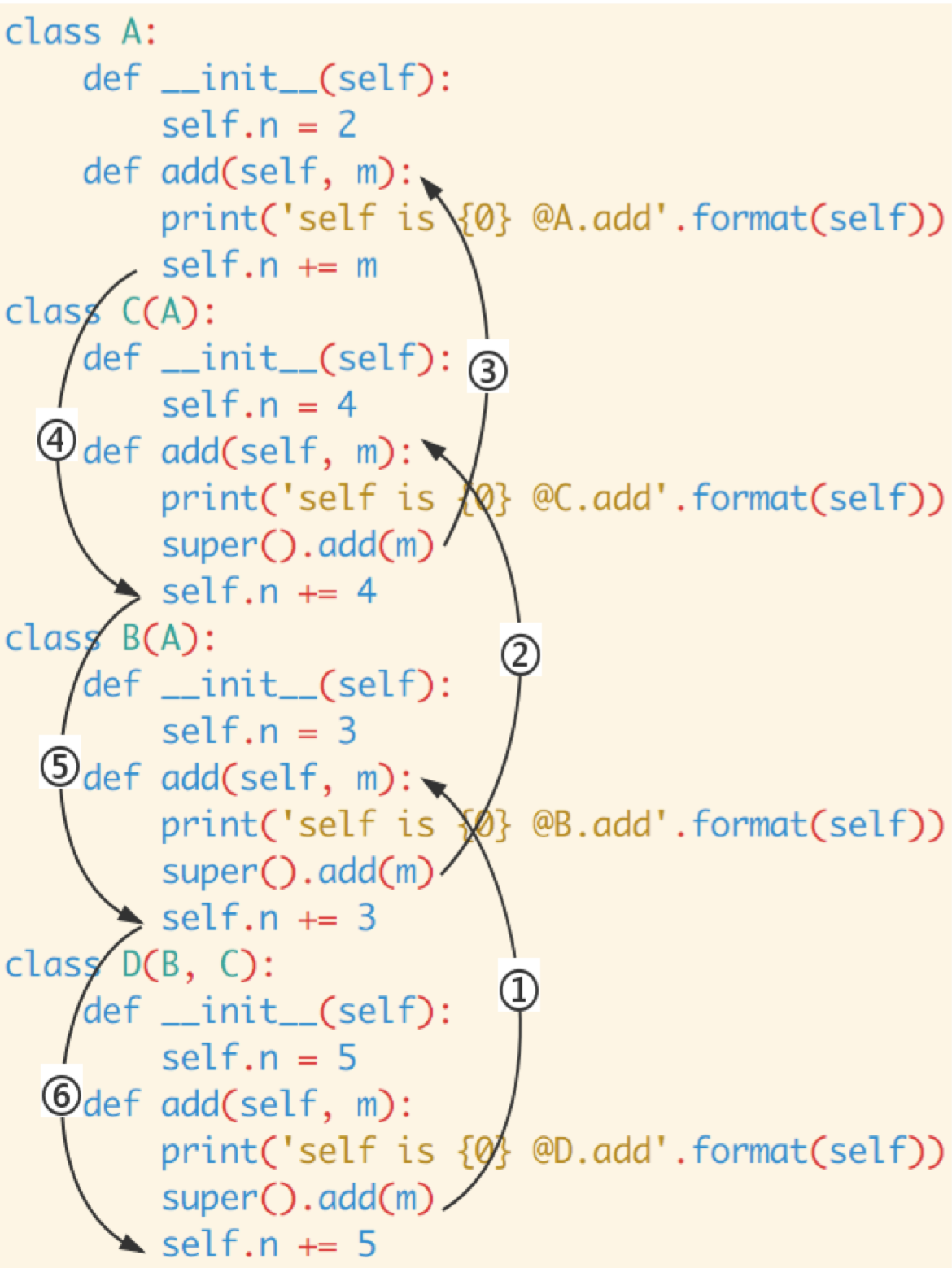

- 多继承

这次我们再定义一个 class C,一个 class D:

class C(A):

def __init__(self):

self.n = 4

def add(self, m):

print('self is {0} @C.add'.format(self))

super().add(m)

self.n += 4

class D(B, C):

def __init__(self):

self.n = 5

def add(self, m):

print('self is {0} @D.add'.format(self))

super().add(m)

self.n += 5

下面的代码又输出啥呢?

d = D()

d.add(2)

print(d.n)

这次的输出如下:

self is <__main__.D object at 0x10ce10e48> @D.add

self is <__main__.D object at 0x10ce10e48> @B.add

self is <__main__.D object at 0x10ce10e48> @C.add

self is <__main__.D object at 0x10ce10e48> @A.add

19

你说对了吗?你可能会认为上面代码的输出类似:

self is <__main__.D object at 0x10ce10e48> @D.add

self is <__main__.D object at 0x10ce10e48> @B.add

self is <__main__.D object at 0x10ce10e48> @A.add

15

为什么会跟预期的不一样呢?下面我们将一起来看看 super 的奥秘。

- super 是个类

当我们调用 super() 的时候,实际上是实例化了一个 super 类。你没看错, super 是个类,既不是关键字也不是函数等其他数据结构:

>>> class A: pass

...

>>> s = super(A)

>>> type(s)

<class 'super'>

>>>

在大多数情况下, super 包含了两个非常重要的信息: **一个 MRO 以及 MRO 中的一个类。**当以如下方式调用 super 时:

super(a_type, obj)

MRO 指的是 type(obj) 的 MRO, MRO 中的那个类就是 a_type , 同时 isinstance(obj, a_type) == True 。

当这样调用时:

super(type1, type2)

MRO 指的是 type2 的 MRO, MRO 中的那个类就是 type1 ,同时 issubclass(type2, type1) == True 。

那么, super() 实际上做了啥呢?简单来说就是:提供一个 MRO 以及一个 MRO 中的类 C , super() 将返回一个从 MRO 中 C 之后的类中查找方法的对象。

也就是说,查找方式时不是像常规方法一样从所有的 MRO 类中查找,而是从 MRO 的 tail 中查找。

举个例子, 有个 MRO:

[A, B, C, D, E, object]

下面的调用:

super(C, A).foo()

super 只会从 C 之后查找,即: 只会在 D 或 E 或 object 中查找 foo 方法。

- 多继承中 super 的工作方式

再回到前面的

d = D()

d.add(2)

print(d.n)

现在你可能已经有点眉目,为什么输出会是

self is <__main__.D object at 0x10ce10e48> @D.add

self is <__main__.D object at 0x10ce10e48> @B.add

self is <__main__.D object at 0x10ce10e48> @C.add

self is <__main__.D object at 0x10ce10e48> @A.add

19

了吧 ;)

下面我们来具体分析一下:

-

D 的 MRO 是: [D, B, C, A, object] 。 备注: 可以通过 D.mro() (Python 2 使用 D.mro ) 来查看 D 的 MRO 信息)

-

详细的代码分析如下:

class A: def __init__(self): self.n = 2 def add(self, m): # 第四步 # 来自 D.add 中的 super # self == d, self.n == d.n == 5 print('self is {0} @A.add'.format(self)) self.n += m # d.n == 7 class B(A): def __init__(self): self.n = 3 def add(self, m): # 第二步 # 来自 D.add 中的 super # self == d, self.n == d.n == 5 print('self is {0} @B.add'.format(self)) # 等价于 suepr(B, self).add(m) # self 的 MRO 是 [D, B, C, A, object] # 从 B 之后的 [C, A, object] 中查找 add 方法 super().add(m) # 第六步 # d.n = 11 self.n += 3 # d.n = 14 class C(A): def __init__(self): self.n = 4 def add(self, m): # 第三步 # 来自 B.add 中的 super # self == d, self.n == d.n == 5 print('self is {0} @C.add'.format(self)) # 等价于 suepr(C, self).add(m) # self 的 MRO 是 [D, B, C, A, object] # 从 C 之后的 [A, object] 中查找 add 方法 super().add(m) # 第五步 # d.n = 7 self.n += 4 # d.n = 11 class D(B, C): def __init__(self): self.n = 5 def add(self, m): # 第一步 print('self is {0} @D.add'.format(self)) # 等价于 super(D, self).add(m) # self 的 MRO 是 [D, B, C, A, object] # 从 D 之后的 [B, C, A, object] 中查找 add 方法 super().add(m) # 第七步 # d.n = 14 self.n += 5 # self.n = 19 d = D() d.add(2) print(d.n)调用过程图如下:

D.mro() == [D, B, C, A, object] d = D() d.n == 5 d.add(2) class D(B, C): class B(A): class C(A): class A: def add(self, m): def add(self, m): def add(self, m): def add(self, m): super().add(m) 1.---> super().add(m) 2.---> super().add(m) 3.---> self.n += m self.n += 5 <------6. self.n += 3 <----5. self.n += 4 <----4. <--| (14+5=19) (11+3=14) (7+4=11) (5+2=7)

现在你知道为什么 d.add(2) 后 d.n 的值是 19 了吧 ;)

计算两个集合之间的距离

- Function Reference

Distance matrix computation from a collection of raw observation vectors stored in a rectangular array.

pdist(X[, metric]) |

Pairwise distances between observations in n-dimensional space. |

|---|---|

cdist(XA, XB[, metric]) |

Compute distance between each pair of the two collections of inputs. |

squareform(X[, force, checks]) |

Convert a vector-form distance vector to a square-form distance matrix, and vice-versa. |

directed_hausdorff(u, v[, seed]) |

Compute the directed Hausdorff distance between two N-D arrays. |

Predicates for checking the validity of distance matrices, both condensed and redundant. Also contained in this module are functions for computing the number of observations in a distance matrix.

is_valid_dm(D[, tol, throw, name, warning]) |

Return True if input array is a valid distance matrix. |

|---|---|

is_valid_y(y[, warning, throw, name]) |

Return True if the input array is a valid condensed distance matrix. |

num_obs_dm(d) |

Return the number of original observations that correspond to a square, redundant distance matrix. |

num_obs_y(Y) |

Return the number of original observations that correspond to a condensed distance matrix. |

Distance functions between two numeric vectors u and v. Computing distances over a large collection of vectors is inefficient for these functions. Use pdist for this purpose.

braycurtis(u, v[, w]) |

Compute the Bray-Curtis distance between two 1-D arrays. |

|---|---|

canberra(u, v[, w]) |

Compute the Canberra distance between two 1-D arrays. |

chebyshev(u, v[, w]) |

Compute the Chebyshev distance. |

cityblock(u, v[, w]) |

Compute the City Block (Manhattan) distance. |

correlation(u, v[, w, centered]) |

Compute the correlation distance between two 1-D arrays. |

cosine(u, v[, w]) |

Compute the Cosine distance between 1-D arrays. |

euclidean(u, v[, w]) |

Computes the Euclidean distance between two 1-D arrays. |

mahalanobis(u, v, VI) |

Compute the Mahalanobis distance between two 1-D arrays. |

minkowski(u, v[, p, w]) |

Compute the Minkowski distance between two 1-D arrays. |

seuclidean(u, v, V) |

Return the standardized Euclidean distance between two 1-D arrays. |

sqeuclidean(u, v[, w]) |

Compute the squared Euclidean distance between two 1-D arrays. |

wminkowski(u, v, p, w) |

Compute the weighted Minkowski distance between two 1-D arrays. |

Distance functions between two boolean vectors (representing sets) u and v. As in the case of numerical vectors, pdist is more efficient for computing the distances between all pairs.

dice(u, v[, w]) |

Compute the Dice dissimilarity between two boolean 1-D arrays. |

|---|---|

hamming(u, v[, w]) |

Compute the Hamming distance between two 1-D arrays. |

jaccard(u, v[, w]) |

Compute the Jaccard-Needham dissimilarity between two boolean 1-D arrays. |

kulsinski(u, v[, w]) |

Compute the Kulsinski dissimilarity between two boolean 1-D arrays. |

rogerstanimoto(u, v[, w]) |

Compute the Rogers-Tanimoto dissimilarity between two boolean 1-D arrays. |

russellrao(u, v[, w]) |

Compute the Russell-Rao dissimilarity between two boolean 1-D arrays. |

sokalmichener(u, v[, w]) |

Compute the Sokal-Michener dissimilarity between two boolean 1-D arrays. |

sokalsneath(u, v[, w]) |

Compute the Sokal-Sneath dissimilarity between two boolean 1-D arrays. |

yule(u, v[, w]) |

Compute the Yule dissimilarity between two boolean 1-D arrays. |

hamming also operates over discrete numerical vectors.

当调用类中未定义的属性或方法时,采用__getattr__可以防止出现错误

1.__getattr__示例:

class Test(object):

def __init__(self,name):

self.name = name

def __getattr__(self, value):

if value == 'address':

return 'China'

if __name__=="__main__":

test = Test('letian')

print test.name

print test.address

test.address = 'Anhui'

print test.address

运行结果:

letian

China

Anhui

如果是调用了一个类中未定义的方法,则__getattr__也要返回一个方法,例如:

class Test(object):

def __init__(self,name):

self.name = name

def __getattr__(self, value):

return len

if __name__=="__main__":

test = Test('letian')

print test.getlength('letian')

运行结果:

6

2.__getattribute__示例:

class Test(object):

def __init__(self,name):

self.name = name

def __getattribute__(self, value):

if value == 'address':

return 'China'

if __name__=="__main__":

test = Test('letian')

print test.name

print test.address

test.address = 'Anhui'

print test.address

运行结果:

None

China

China

描述

isinstance() 函数来判断一个对象是否是一个已知的类型,类似 type()。

isinstance() 与 type() 区别:

- type() 不会认为子类是一种父类类型,不考虑继承关系。

- isinstance() 会认为子类是一种父类类型,考虑继承关系。

如果要判断两个类型是否相同推荐使用 isinstance()。

语法

以下是 isinstance() 方法的语法:

isinstance(object, classinfo)

参数

-

object -- 实例对象。

-

classinfo -- 可以是直接或间接类名、基本类型或者由它们组成的元组。

返回

如果对象的类型与参数二的类型(classinfo)相同则返回 True,否则返回 False。。

- 实例

以下展示了使用 isinstance 函数的实例:

>>>a = 2

>>> isinstance (a,int)

True

>>> isinstance (a,str)

False

>>> isinstance (a,(str,int,list)) # 是元组中的一个返回 True

True

- type() 与 isinstance()区别:

class A:

pass

class B(A):

pass

isinstance(A(), A) # returns True

type(A()) == A # returns True

isinstance(B(), A) # returns True

type(B()) == A # returns False

**描述:**all() 函数用于判断给定的可迭代参数 iterable 中的所有元素是否都为 TRUE,如果是返回 True,

否则返回 False。元素除了是 0、空、FALSE 外都算 TRUE。

函数等价于:

def all(iterable):

for element in iterable:

if not element:

return False

return True

- 语法

以下是 all() 方法的语法:

all(iterable)

参数

- iterable -- 元组或列表。

返回值

如果iterable的所有元素不为0、''、False或者iterable为空,all(iterable)返回True,否则返回False;

**注意:**空元组、空列表返回值为True,这里要特别注意。

>>>all(['a', 'b', 'c', 'd']) # 列表list,元素都不为空或0

True

>>> all(['a', 'b', '', 'd']) # 列表list,存在一个为空的元素

False

>>> all([0, 1,2, 3]) # 列表list,存在一个为0的元素

False

>>> all(('a', 'b', 'c', 'd')) # 元组tuple,元素都不为空或0

True

>>> all(('a', 'b', '', 'd')) # 元组tuple,存在一个为空的元素

False

>>> all((0, 1, 2, 3)) # 元组tuple,存在一个为0的元素

False

>>> all([]) # 空列表

True

>>> all(()) # 空元组

True

- any()

any(...)

any(iterable) -> bool

Return True if bool(x) is True for any x in the iterable.

If the iterable is empty, return False.any(iterable)

说明:参数iterable:可迭代对象;

如果当iterable所有的值都是0、''或False时,那么结果为False,如果所有元素中有一个值非0、''或False,那么结果就为True。只要有一个元素值非0、False、空的话那么返回的就是True.

函数等价于:

def any(iterable):

for element in iterable:

if element:

return False

return True

示例如下:

>>> any(['a', 'b', 'c', 'd']) #列表list,元素都不为空或0

True

>>> any(['a', 'b', '', 'd']) #列表list,存在一个为空的元素

True

>>> any([0, '', False]) #列表list,元素全为0,'',false

False

>>> any(('a', 'b', 'c', 'd')) #元组tuple,元素都不为空或0

True

>>> any(('a', 'b', '', 'd')) #元组tuple,存在一个为空的元素

True

>>> any((0, '', False)) #元组tuple,元素全为0,'',false

False

>>> any([]) # 空列表

False

>>> any(()) # 空元组

False

numpy.dtype.kind

dtype.kind

A character code (one of ‘biufcmMOSUV’) identifying the general kind of data.

b boolean

i signed integer

u unsigned integer

f floating-point

c complex floating-point

m timedelta

M datetime

O object

S (byte-)string

U Unicode

V voids

实例如下:

import numpy as np

np.asarray([1,5]).dtype.kind

Out[129]: 'i'

np.asarray([1,5]).dtype

Out[130]: dtype('int32')

sys模块

sys模块主要是用于提供对python解释器相关的操作

函数

- sys.argv #命令行参数List,第一个元素是程序本身路径

- sys.path #返回模块的搜索路径,初始化时使用PYTHONPATH环境变量的值

- sys.modules.keys() #返回所有已经导入的模块列表

- sys.modules #返回系统导入的模块字段,key是模块名,value是模块

- sys.exc_info() #获取当前正在处理的异常类,exc_type、exc_value、exc_traceback当前处理的异常详细信息

- sys.exit(n) #退出程序,正常退出时exit(0)

- sys.hexversion #获取Python解释程序的版本值,16进制格式如:0x020403F0

- sys.version #获取Python解释程序的版本信息

- sys.platform #返回操作系统平台名称

- sys.maxint # 最大的Int值

- sys.stdout #标准输出

- sys.stdout.write('aaa') #标准输出内容

- sys.stdout.writelines() #无换行输出

- sys.stdin #标准输入

- sys.stdin.read() #输入一行

- sys.stderr #错误输出

- sys.exc_clear() #用来清除当前线程所出现的当前的或最近的错误信息

- sys.exec_prefix #返回平台独立的python文件安装的位置

- sys.byteorder #本地字节规则的指示器,big-endian平台的值是'big',little-endian平台的值是'little'

- sys.copyright #记录python版权相关的东西

- sys.api_version #解释器的C的API版本

- sys.version_info #'final'表示最终,也有'candidate'表示候选,表示版本级别,是否有后继的发行

- sys.getdefaultencoding() #返回当前你所用的默认的字符编码格式

- sys.getfilesystemencoding() #返回将Unicode文件名转换成系统文件名的编码的名字

- sys.builtin_module_names #Python解释器导入的内建模块列表

- sys.executable #Python解释程序路径

- sys.getwindowsversion() #获取Windows的版本

- sys.stdin.readline() #从标准输入读一行,sys.stdout.write(a) 屏幕输出a

- sys.setdefaultencoding(name) #用来设置当前默认的字符编码(详细使用参考文档)

- sys.displayhook(value) #如果value非空,这个函数会把他输出到sys.stdout(详细使用参考文档)

常用功能

sys.arg 获取位置参数

print(sys.argv)

执行该脚本,加参数的打印结果

python3 m_sys.py 1 2 3 4 5

['m_sys.py', '1', '2', '3', '4', '5']

可以发现 sys.arg返回的是整个位置参数,类似于shell的$0 $1...

sys.exit(n) 程序退出,n是退出是返回的对象

sys.version 获取python版本

>>> sys.version

'3.5.1 (v3.5.1:37a07cee5969, Dec 5 2015, 21:12:44) \n[GCC 4.2.1 (Apple Inc. build 5666) (dot 3)]'

sys.path 返回模块的搜索路径列表,可通过添加自定义路径,来添加自定义模块

>>> sys.path

['', '/Library/Frameworks/Python.framework/Versions/3.5/lib/python35.zip', '/Library/Frameworks/Python.framework/Versions/3.5/lib/python3.5', '/Library/Frameworks/Python.framework/Versions/3.5/lib/python3.5/plat-darwin', '/Library/Frameworks/Python.framework/Versions/3.5/lib/python3.5/lib-dynload', '/Library/Frameworks/Python.framework/Versions/3.5/lib/python3.5/site-packages']

sys.platform 返回当前系统平台 linux平台返回linux,windows平台返回win32,MAC返回darwin

>>> sys.platform

'darwin

sys.stdout.write() 输出内容

>>> sys.stdout.write('asd')

asd3

>>> sys.stdout.write('asd')

asd3

>>> sys.stdout.write('as')

as2

应用:

进度条:

#!/usr/bin/env python

# -*- coding: UTF-8 -*-

#pyversion:python3.5

#owner:fuzj

"""

sys 和python解析器相关

"""

import sys

import time

def view_bar(num,total):

rate = num / total

rate_num = int(rate * 100)

#r = '\r %d%%' %(rate_num)

r = '\r%s>%d%%' % ('=' * rate_num, rate_num,)

sys.stdout.write(r)

sys.stdout.flush

if __name__ == '__main__':

for i in range(0, 101):

time.sleep(0.1)

view_bar(i, 100)

效果:

====================================================================================================>100%

os模块

OS模块是Python标准库中的一个用于**访问操作系统功能的模块,**使用OS模块中提供的接口,可以实现跨平台访问

用于提供系统级别的操作

- os.getcwd() 获取当前工作目录,即当前python脚本工作的目录路径

- os.chdir(dirname) 改变当前脚本工作目录;相当于shell下cd

- os.curdir 返回当前目录: ('.')

- os.pardir 获取当前目录的父目录字符串名:('..')

- os.makedirs('dir1/dir2') 可生成多层递归目录

- os.removedirs('dirname1') 若目录为空,则删除,并递归到上一级目录,如若也为空,则删除,依此类推

- os.mkdir('dirname') 生成单级目录;相当于shell中mkdir dirname

- os.rmdir('dirname') 删除单级空目录,若目录不为空则无法删除,报错;相当于shell中rmdir dirname

- os.listdir('dirname') 列出指定目录下的所有文件和子目录,包括隐藏文件,并以列表方式打印

- os.remove() 删除一个文件

- os.rename(oldname,new) 重命名文件/目录

- os.stat('path/filename') 获取文件/目录信息

- os.sep 操作系统特定的路径分隔符,win下为,Linux下为/

- os.linesep 当前平台使用的行终止符,win下为\t\n,Linux下为\n

- os.pathsep 用于分割文件路径的字符串

- os.name 字符串指示当前使用平台。win->'nt'; Linux->'posix'

- os.system(bash command) 运行shell命令,直接显示

- os.environ 获取系统环境变量

- os.path.abspath(path) 返回path规范化的绝对路径

- os.path.split(path) 将path分割成目录和文件名二元组返回

- os.path.dirname(path) 返回path的目录。其实就是os.path.split(path)的第一个元素

- os.path.basename(path) 返回path最后的文件名。如何path以/或\结尾,那么就会返回空值。即os.path.split(path)的第二个元素

- os.path.exists(path) 如果path存在,返回True;如果path不存在,返回False

- os.path.lexists #路径存在则返回True,路径损坏也返回True

- os.path.isabs(path) 如果path是绝对路径,返回True

- os.path.isfile(path) 如果path是一个存在的文件,返回True。否则返回False

- os.path.isdir(path) 如果path是一个存在的目录,则返回True。否则返回False

- os.path.join(path1[, path2[, ...]]) 将多个路径组合后返回,第一个绝对路径之前的参数将被忽略

- os.path.getatime(path) 返回path所指向的文件或者目录的最后存取时间

- os.path.getmtime(path) 返回path所指向的文件或者目录的最后修改时间

- os.path.commonprefix(list) #返回list(多个路径)中,所有path共有的最长的路径。

- os.path.expanduser(path) #把path中包含的"~"和"~user"转换成用户目录

- os.path.expandvars(path) #根据环境变量的值替换path中包含的”$name”和”${name}”

- os.access('pathfile',os.W_OK) 检验文件权限模式,输出True,False

- os.chmod('pathfile',os.W_OK) 改变文件权限模式

作用:

将字符串str当成有效的表达式来求值并返回计算结果。参数:source:一个Python表达式或函数compile()返回的代码对象;globals:可选。必须是dictionary;locals:可选。任意map对象。

实例:

#################################################

字符串转换成列表

>>>a = "[[1,2], [3,4], [5,6], [7,8], [9,0]]"

>>>type(a)

<type 'str'>

>>> b = eval(a)

>>> print b

[[1, 2], [3, 4], [5, 6], [7, 8], [9, 0]]

>>> type(b)

<type 'list'>

#################################################

字符串转换成字典

>>> a = "{1: 'a', 2: 'b'}"

>>> type(a)

<type 'str'>

>>> b = eval(a)

>>> print b

{1: 'a', 2: 'b'}

>>> type(b)

<type 'dict'>

#################################################

字符串转换成元组

>>> a = "([1,2], [3,4], [5,6], [7,8], (9,0))"

>>> type(a)

<type 'str'>

>>> b = eval(a)

>>> print b

([1, 2], [3, 4], [5, 6], [7, 8], (9, 0))

>>> type(b)

<type 'tuple'>

当我使用普通的字典时,用法一般是dict={},添加元素的只需要dict[element] =value即,调用的时候也是如此,dict[element] = xxx,但前提是element字典里,如果不在字典里就会报错,如:

这时defaultdict就能排上用场了,defaultdict的作用是在于,当字典里的key不存在但被查找时,返回的不是keyError而是一个默认值,这个默认值是什么呢,下面会说

如何使用defaultdict defaultdict接受一个工厂函数作为参数,如下来构造:

dict =defaultdict( factory_function)

这个factory_function可以是list、set、str等等,作用是当key不存在时,返回的是工厂函数的默认值,比如list对应[ ],str对应的是空字符串,set对应set( ),int对应0,如下举例:

from collections import defaultdict

dict1 = defaultdict(int)

dict2 = defaultdict(set)

dict3 = defaultdict(str)

dict4 = defaultdict(list)

dict1[2] ='two'

print(dict1[1])

print(dict2[1])

print(dict3[1])

print(dict4[1])

输出:

0 set()

[]

描述

enumerate() 函数用于将一个可遍历的数据对象(如列表、元组或字符串)组合为一个索引序列,同时列出数据和数据下标,一般用在 for 循环当中。

Python 2.3. 以上版本可用,2.6 添加 start 参数。

语法

以下是 enumerate() 方法的语法:

enumerate(sequence, [start=0])

参数

- sequence -- 一个序列、迭代器或其他支持迭代对象。

- start -- 下标起始位置。

返回值

返回 enumerate(枚举) 对象。

实例

以下展示了使用 enumerate() 方法的实例:

>>>seasons = ['Spring', 'Summer', 'Fall', 'Winter']

>>>list(enumerate(seasons))

[(0, 'Spring'), (1, 'Summer'), (2, 'Fall'), (3, 'Winter')]

>>>list(enumerate(seasons, start=1)) # 下标从 1 开始

[(1, 'Spring'), (2, 'Summer'), (3, 'Fall'), (4, 'Winter')]

普通的 for 循环

>>>i = 0

>>> seq = ['one', 'two', 'three']

>>> for element in seq:

print i, seq[i]

i +=1

... 0 one

1 two

2 three

for 循环使用 enumerate

>>>seq = ['one', 'two', 'three']

>>>for i, element in enumerate(seq):

>>>... print i, element

0 one

1 two

2 three

在绑定属性时,如果我们直接把属性暴露出去,虽然写起来很简单,但是,没办法检查参数,导致可以把成绩随便改:

s = Student()

s.score = 9999

这显然不合逻辑。为了限制score的范围,可以通过一个set_score()方法来设置成绩,再通过一个get_score()来获取成绩,这样,在set_score()方法里,就可以检查参数:

class Student(object):

def get_score(self):

return self._score

def set_score(self, value):

if not isinstance(value, int):

raise ValueError('score must be an integer!')

if value < 0 or value > 100:

raise ValueError('score must between 0 ~ 100!')

self._score = value

现在,对任意的Student实例进行操作,就不能随心所欲地设置score了:

>>> s = Student()

>>> s.set_score(60) # ok!

>>> s.get_score()

60

>>> s.set_score(9999)

Traceback (most recent call last):

...

ValueError: score must between 0 ~ 100!

但是,上面的调用方法又略显复杂,没有直接用属性这么直接简单。

有没有既能检查参数,又可以用类似属性这样简单的方式来访问类的变量呢?对于追求完美的Python程序员来说,这是必须要做到的!

还记得装饰器(decorator)可以给函数动态加上功能吗?对于类的方法,装饰器一样起作用。Python内置的@property装饰器就是负责把一个方法变成属性调用的:

class Student(object):

@property

def score(self):

return self._score

@score.setter

def score(self, value):

if not isinstance(value, int):

raise ValueError('score must be an integer!')

if value < 0 or value > 100:

raise ValueError('score must between 0 ~ 100!')

self._score = value

@property的实现比较复杂,我们先考察如何使用。把一个getter方法变成属性,只需要加上@property就可以了,此时,@property本身又创建了另一个装饰器@score.setter,负责把一个setter方法变成属性赋值,于是,我们就拥有一个可控的属性操作:

>>> s = Student()

>>> s.score = 60 # OK,实际转化为s.set_score(60)

>>> s.score # OK,实际转化为s.get_score()

60

>>> s.score = 9999

Traceback (most recent call last):

...

ValueError: score must between 0 ~ 100!

注意到这个神奇的@property,我们在对实例属性操作的时候,就知道该属性很可能不是直接暴露的,而是通过getter和setter方法来实现的。

还可以定义只读属性,只定义getter方法,不定义setter方法就是一个只读属性:

class Student(object):

@property

def birth(self):

return self._birth

@birth.setter

def birth(self, value):

self._birth = value

@property

def age(self):

return 2014 - self._birth

上面的birth是可读写属性,而age就是一个只读属性,因为age可以根据birth和当前时间计算出来。

小结

Stashed changes

@property广泛应用在类的定义中,可以让调用者写出简短的代码,同时保证对参数进行必要的检查,这样,程序运行时就减少了出错的可能性。

在python数据分析的学习和应用过程中,经常需要用到numpy的随机函数,由于随机函数random的功能比较多,经常会混淆或记不住,下面我们一起来汇总学习下。

import numpy as np0 np.random.random()

numpy.random.random(*size=None*)

Return random floats in the half-open interval [0.0, 1.0).

Results are from the “continuous uniform” distribution over the stated interval. To sample ![Unifa, b), b > a multiply the output of random_sample by (b-a) and add a:

(b - a) * random_sample() + a

| Parameters: | size : int or tuple of ints, optionalOutput shape. If the given shape is, e.g., (m, n, k), then m * n * k samples are drawn. Default is None, in which case a single value is returned. |

|---|---|

| Returns: | out : float or ndarray of floatsArray of random floats of shape size (unless size=None, in which case a single float is returned). |

Examples

>>>

>>> np.random.random_sample()

0.47108547995356098

>>> type(np.random.random_sample())

<type 'float'>

>>> np.random.random_sample((5,))

array([ 0.30220482, 0.86820401, 0.1654503 , 0.11659149, 0.54323428])

Three-by-two array of random numbers from [-5, 0):

>>>

>>> 5 * np.random.random_sample((3, 2)) - 5

array([[-3.99149989, -0.52338984],

[-2.99091858, -0.79479508],

[-1.23204345, -1.75224494]])

1 numpy.random.rand()

numpy.random.rand(d0,d1,…,dn)

- rand函数根据给定维度生成[0,1)之间的数据,包含0,不包含1

- dn表格每个维度

- 返回值为指定维度的array

np.random.rand(4,2)

array([[ 0.02173903, 0.44376568],

[ 0.25309942, 0.85259262],

[ 0.56465709, 0.95135013],

[ 0.14145746, 0.55389458]])

np.random.rand(4,3,2) # shape: 4*3*2

array([[[ 0.08256277, 0.11408276],

[ 0.11182496, 0.51452019],

[ 0.09731856, 0.18279204]],

[[ 0.74637005, 0.76065562],

[ 0.32060311, 0.69410458],

[ 0.28890543, 0.68532579]],

[[ 0.72110169, 0.52517524],

[ 0.32876607, 0.66632414],

[ 0.45762399, 0.49176764]],

[[ 0.73886671, 0.81877121],

[ 0.03984658, 0.99454548],

[ 0.18205926, 0.99637823]]])numpy.random.rand

numpy.random.rand(d0, d1, ..., dn)

Random values in a given shape.

Create an array of the given shape and populate it with random samples from a uniform distribution over [0, 1).

Parameters:

d0, d1, …, dn : int, optional

The dimensions of the returned array, should all be positive. If no argument is given a single Python float is returned.

Returns:

out : ndarray, shape (d0, d1, ..., dn)

Random values.

See also

random

Notes

This is a convenience function. If you want an interface that takes a shape-tuple as the first argument, refer to np.random.random_sample .

Examples

>>>

>>> np.random.rand(3,2)

array([[ 0.14022471, 0.96360618], #random

[ 0.37601032, 0.25528411], #random

[ 0.49313049, 0.94909878]]) #random

2 numpy.random.randn()

numpy.random.randn(d0,d1,…,dn)

- randn函数返回一个或一组样本,具有标准正态分布。

- dn表格每个维度

- 返回值为指定维度的array

np.random.randn() # 当没有参数时,返回单个数据

-1.1241580894939212

np.random.randn(2,4)

array([[ 0.27795239, -2.57882503, 0.3817649 , 1.42367345],

[-1.16724625, -0.22408299, 0.63006614, -0.41714538]])

np.random.randn(4,3,2)

array([[[ 1.27820764, 0.92479163],

[-0.15151257, 1.3428253 ],

[-1.30948998, 0.15493686]],

[[-1.49645411, -0.27724089],

[ 0.71590275, 0.81377671],

[-0.71833341, 1.61637676]],

[[ 0.52486563, -1.7345101 ],

[ 1.24456943, -0.10902915],

[ 1.27292735, -0.00926068]],

[[ 0.88303 , 0.46116413],

[ 0.13305507, 2.44968809],

[-0.73132153, -0.88586716]]])标准正态分布介绍

- 标准正态分布—-standard normal distribution

- 标准正态分布又称为u分布,是以0为均值、以1为标准差的正态分布,记为N(0,1)。

3 numpy.random.randint()

3.1 numpy.random.randint()

numpy.random.randint(low, high=None, size=None, dtype=’l’)

- 返回随机整数,范围区间为[low,high),包含low,不包含high

- 参数:low为最小值,high为最大值,size为数组维度大小,dtype为数据类型,默认的数据类型是np.int

- high没有填写时,默认生成随机数的范围是[0,low)

np.random.randint(1,size=5) # 返回[0,1)之间的整数,所以只有0

array([0, 0, 0, 0, 0])

np.random.randint(1,5) # 返回1个[1,5)时间的随机整数

4

np.random.randint(-5,5,size=(2,2))

array([[ 2, -1],

[ 2, 0]])3.2 numpy.random.random_integers

numpy.random.random_integers(low, high=None, size=None)

- 返回随机整数,范围区间为[low,high],包含low和high

- 参数:low为最小值,high为最大值,size为数组维度大小

- high没有填写时,默认生成随机数的范围是[1,low]

该函数在最新的numpy版本中已被替代,建议使用randint函数

np.random.random_integers(1,size=5)

array([1, 1, 1, 1, 1])4 生成[0,1)之间的浮点数

- numpy.random.random_sample(size=None)

- numpy.random.random(size=None)

- numpy.random.ranf(size=None)

- numpy.random.sample(size=None)

print('-----------random_sample--------------')

print(np.random.random_sample(size=(2,2)))

print('-----------random--------------')

print(np.random.random(size=(2,2)))

print('-----------ranf--------------')

print(np.random.ranf(size=(2,2)))

print('-----------sample--------------')

print(np.random.sample(size=(2,2)))

-----------random_sample--------------

[[ 0.34966859 0.85655008]

[ 0.16045328 0.87908218]]

-----------random--------------

[[ 0.25303772 0.45417512]

[ 0.76053763 0.12454433]]

-----------ranf--------------

[[ 0.0379055 0.51288667]

[ 0.71819639 0.97292903]]

-----------sample--------------

[[ 0.59942807 0.80211491]

[ 0.36233939 0.12607092]]5 numpy.random.choice()

numpy.random.choice(a, size=None, replace=True, p=None)

- 从给定的一维数组中生成随机数

- 参数: a为一维数组类似数据或整数;size为数组维度;p为数组中的数据出现的概率

- a为整数时,对应的一维数组为np.arange(a)

np.random.choice(5,3)

array([4, 1, 4])

np.random.choice(5, 3, replace=False)

# 当replace为False时,生成的随机数不能有重复的数值

array([0, 3, 1])

np.random.choice(5,size=(3,2))

array([[1, 0],

[4, 2],

[3, 3]])

demo_list = ['lenovo', 'sansumg','moto','xiaomi', 'iphone']

np.random.choice(demo_list,size=(3,3))

array([['moto', 'iphone', 'xiaomi'],

['lenovo', 'xiaomi', 'xiaomi'],

['xiaomi', 'lenovo', 'iphone']],

dtype='<U7')- 参数p的长度与参数a的长度需要一致;

- 参数p为概率,p里的数据之和应为1

demo_list = ['lenovo', 'sansumg','moto','xiaomi', 'iphone']

np.random.choice(demo_list,size=(3,3), p=[0.1,0.6,0.1,0.1,0.1])

array([['sansumg', 'sansumg', 'sansumg'],

['sansumg', 'sansumg', 'sansumg'],

['sansumg', 'xiaomi', 'iphone']],

dtype='<U7')6 numpy.random.seed()

- np.random.seed()的作用:使得随机数据可预测。

- 当我们设置相同的seed,每次生成的随机数相同。如果不设置seed,则每次会生成不同的随机数

np.random.seed(0)

np.random.rand(5)

array([ 0.5488135 , 0.71518937, 0.60276338, 0.54488318, 0.4236548 ])

np.random.seed(1676)

np.random.rand(5)

array([ 0.39983389, 0.29426895, 0.89541728, 0.71807369, 0.3531823 ])

np.random.seed(1676)

np.random.rand(5)

array([ 0.39983389, 0.29426895, 0.89541728, 0.71807369, 0.3531823 ]) 描述

callable() 函数用于检查一个对象是否是可调用的。如果返回True,object仍然可能调用失败;但如果返回False,调用对象ojbect绝对不会成功。

对于函数, 方法, lambda 函式, 类, 以及实现了 call 方法的类实例, 它都返回 True。

语法

callable()方法语法:

callable(object)

参数

- object -- 对象

返回值

可调用返回 True,否则返回 False。

实例

以下实例展示了 callable() 的使用方法:

>>>callable(0)

False

>>> callable("runoob")

False

>>> def add(a, b):

... return a + b

...

>>> callable(add) # 函数返回 True

True

>>> class A: # 类

... def method(self):

... return 0

...

>>> callable(A) # 类返回 True

True

>>> a = A()

>>> callable(a) # 没有实现 __call__, 返回 False

False

>>> class B:

... def __call__(self):

... return 0

...

>>> callable(B)

True

>>> b = B()

>>> callable(b) # 实现 __call__, 返回 True

True

__repr__和__str__这两个方法都是用于显示的,__str__是面向用户的,而__repr__面向程序员。

-

打印操作会首先尝试__str__和str内置函数(print运行的内部等价形式),它通常应该返回一个友好的显示。

-

repr__用于所有其他的环境中:用于交互模式下提示回应以及repr函数,如果没有使用__str,会使用print和str。它通常应该返回一个编码字符串,可以用来重新创建对象,或者给开发者详细的显示。

当我们想所有环境下都统一显示的话,可以重构__repr__方法;当我们想在不同环境下支持不同的显示,例如终端用户显示使用__str__,而程序员在开发期间则使用底层的__repr__来显示,实际上__str__只是覆盖了__repr__以得到更友好的用户显示。

如果要把一个类的实例变成 str,就需要实现特殊方法__str__():

class Person(object):

def __init__(self, name, gender):

self.name = name

self.gender = gender

def __str__(self):

return '(Person: %s, %s)' % (self.name, self.gender)

现在,在交互式命令行下用 print 试试:

>>> p = Person('Bob', 'male')

>>> print p

(Person: Bob, male)

但是,如果直接敲变量 p:

>>> p

<main.Person object at 0x10c941890>

似乎__str__() 不会被调用。

因为 Python 定义了**str()和repr()两种方法,str()用于显示给用户,而repr()**用于显示给开发人员。

有一个偷懒的定义__repr__的方法:

class Person(object):

def __init__(self, name, gender):

self.name = name

self.gender = gender

def __str__(self):

return '(Person: %s, %s)' % (self.name, self.gender)

__repr__ = __str__

任务

请给Student 类定义**str和repr**方法,使得能打印出<Student: name, gender, score>:

class Student(Person):

def __init__(self, name, gender, score):

super(Student, self).__init__(name, gender)

self.score = score

来自廖雪峰python官网

其他参考:http://www.runoob.com/python/python-reg-expressions.html

字符串是编程时涉及到的最多的一种数据结构,对字符串进行操作的需求几乎无处不在。比如判断一个字符串是否是合法的Email地址,虽然可以编程提取@前后的子串,再分别判断是否是单词和域名,但这样做不但麻烦,而且代码难以复用。

正则表达式是一种用来匹配字符串的强有力的武器。它的设计思想是用一种描述性的语言来给字符串定义一个规则,凡是符合规则的字符串,我们就认为它“匹配”了,否则,该字符串就是不合法的。

所以我们判断一个字符串是否是合法的Email的方法是:

- 创建一个匹配Email的正则表达式;

- 用该正则表达式去匹配用户的输入来判断是否合法。

因为正则表达式也是用字符串表示的,所以,我们要首先了解如何用字符来描述字符。

在正则表达式中,如果直接给出字符,就是精确匹配。用\d可以匹配一个数字,\w可以匹配一个字母或数字,所以:

'00\d'可以匹配'007',但无法匹配'00A';'\d\d\d'可以匹配'010';'\w\w\d'可以匹配'py3';

.可以匹配任意字符,所以:

'py.'可以匹配'pyc'、'pyo'、'py!'等等。

要匹配变长的字符,在正则表达式中,用*表示任意个字符(包括0个),用+表示至少一个字符,用?表示0个或1个字符,用{n}表示n个字符,用{n,m}表示n-m个字符:

来看一个复杂的例子:\d{3}\s+\d{3,8}。

我们来从左到右解读一下:

\d{3}表示匹配3个数字,例如'010';\s可以匹配一个空格(也包括Tab等空白符),所以\s+表示至少有一个空格,例如匹配' ',' '等;\d{3,8}表示3-8个数字,例如'1234567'。

综合起来,上面的正则表达式可以匹配以任意个空格隔开的带区号的电话号码。

如果要匹配'010-12345'这样的号码呢?由于'-'是特殊字符,在正则表达式中,要用'\'转义,所以,上面的正则是\d{3}\-\d{3,8}。

但是,仍然无法匹配'010 - 12345',因为带有空格。所以我们需要更复杂的匹配方式。

进阶

要做更精确地匹配,可以用[]表示范围,比如:

[0-9a-zA-Z\_]可以匹配一个数字、字母或者下划线;[0-9a-zA-Z\_]+可以匹配至少由一个数字、字母或者下划线组成的字符串,比如'a100','0_Z','Py3000'等等;[a-zA-Z\_][0-9a-zA-Z\_]*可以匹配由字母或下划线开头,后接任意个由一个数字、字母或者下划线组成的字符串,也就是Python合法的变量;[a-zA-Z\_][0-9a-zA-Z\_]{0, 19}更精确地限制了变量的长度是1-20个字符(前面1个字符+后面最多19个字符)。

A|B可以匹配A或B,所以(P|p)ython可以匹配'Python'或者'python'。

^表示行的开头,^\d表示必须以数字开头。

$表示行的结束,\d$表示必须以数字结束。

你可能注意到了,py也可以匹配'python',但是加上^py$就变成了整行匹配,就只能匹配'py'了。

re模块

有了准备知识,我们就可以在Python中使用正则表达式了。Python提供re模块,包含所有正则表达式的功能。由于Python的字符串本身也用\转义,所以要特别注意:

s = 'ABC\\-001' # Python的字符串

# 对应的正则表达式字符串变成:

# 'ABC\-001'

因此我们强烈建议使用Python的r前缀,就不用考虑转义的问题了:

s = r'ABC\-001' # Python的字符串

# 对应的正则表达式字符串不变:

# 'ABC\-001'

先看看如何判断正则表达式是否匹配:

>>> import re

>>> re.match(r'^\d{3}\-\d{3,8}$', '010-12345')

<_sre.SRE_Match object at 0x1026e18b8>

>>> re.match(r'^\d{3}\-\d{3,8}$', '010 12345')

>>>

match()方法判断是否匹配,如果匹配成功,返回一个Match对象,否则返回None。常见的判断方法就是:

test = '用户输入的字符串'

if re.match(r'正则表达式', test):

print 'ok'

else:

print 'failed'

切分字符串

用正则表达式切分字符串比用固定的字符更灵活,请看正常的切分代码:

>>> 'a b c'.split(' ')

['a', 'b', '', '', 'c']

嗯,无法识别连续的空格,用正则表达式试试:

>>> re.split(r'\s+', 'a b c')

['a', 'b', 'c']

无论多少个空格都可以正常分割。加入,试试:

>>> re.split(r'[\s\,]+', 'a,b, c d')

['a', 'b', 'c', 'd']

再加入;试试:

>>> re.split(r'[\s\,\;]+', 'a,b;; c d')

['a', 'b', 'c', 'd']

如果用户输入了一组标签,下次记得用正则表达式来把不规范的输入转化成正确的数组。

- 分组

除了简单地判断是否匹配之外,正则表达式还有提取子串的强大功能。用()表示的就是要提取的分组(Group)。比如:

^(\d{3})-(\d{3,8})$分别定义了两个组,可以直接从匹配的字符串中提取出区号和本地号码:

>>> m = re.match(r'^(\d{3})-(\d{3,8})$', '010-12345')

>>> m

<_sre.SRE_Match object at 0x1026fb3e8>

>>> m.group(0)

'010-12345'

>>> m.group(1)

'010'

>>> m.group(2)

'12345'

如果正则表达式中定义了组,就可以在Match对象上用group()方法提取出子串来。

注意到group(0)永远是原始字符串,group(1)、group(2)……表示第1、2、……个子串。

提取子串非常有用。来看一个更凶残的例子:

>>> t = '19:05:30'

>>> m = re.match(r'^(0[0-9]|1[0-9]|2[0-3]|[0-9])\:(0[0-9]|1[0-9]|2[0-9]|3[0-9]|4[0-9]|5[0-9]|[0-9])\:(0[0-9]|1[0-9]|2[0-9]|3[0-9]|4[0-9]|5[0-9]|[0-9])$', t)

>>> m.groups()

('19', '05', '30')

这个正则表达式可以直接识别合法的时间。但是有些时候,用正则表达式也无法做到完全验证,比如识别日期:

'^(0[1-9]|1[0-2]|[0-9])-(0[1-9]|1[0-9]|2[0-9]|3[0-1]|[0-9])$'

对于'2-30','4-31'这样的非法日期,用正则还是识别不了,或者说写出来非常困难,这时就需要程序配合识别了。

- 贪婪匹配

最后需要特别指出的是,正则匹配默认是贪婪匹配,也就是匹配尽可能多的字符。举例如下,匹配出数字后面的0:

>>> re.match(r'^(\d+)(0*)$', '102300').groups()

('102300', '')

由于\d+采用贪婪匹配,直接把后面的0全部匹配了,结果0*只能匹配空字符串了。

必须让\d+采用非贪婪匹配(也就是尽可能少匹配),才能把后面的0匹配出来,加个?就可以让\d+采用非贪婪匹配:

>>> re.match(r'^(\d+?)(0*)$', '102300').groups()

('1023', '00')

- 编译

当我们在Python中使用正则表达式时,re模块内部会干两件事情:

- 编译正则表达式,如果正则表达式的字符串本身不合法,会报错;

- 用编译后的正则表达式去匹配字符串。

如果一个正则表达式要重复使用几千次,出于效率的考虑,我们可以预编译该正则表达式,接下来重复使用时就不需要编译这个步骤了,直接匹配:

>>> import re

# 编译:

>>> re_telephone = re.compile(r'^(\d{3})-(\d{3,8})$')

# 使用:

>>> re_telephone.match('010-12345').groups()

('010', '12345')

>>> re_telephone.match('010-8086').groups()

('010', '8086')

编译后生成Regular Expression对象,由于该对象自己包含了正则表达式,所以调用对应的方法时不用给出正则字符串。

- 小结

正则表达式非常强大,要在短短的一节里讲完是不可能的。要讲清楚正则的所有内容,可以写一本厚厚的书了。如果你经常遇到正则表达式的问题,你可能需要一本正则表达式的参考书。

请尝试写一个验证Email地址的正则表达式。版本一应该可以验证出类似的Email:

版本二可以验证并提取出带名字的Email地址:

<Tom Paris> [email protected]

- 使用 pdb 进行调试

pdb 是 python 自带的一个包,为 python 程序提供了一种交互的源代码调试功能,主要特性包括设置断点、单步调试、进入函数调试、查看当前代码、查看栈片段、动态改变变量的值等。pdb 提供了一些常用的调试命令,详情见表 1。

- 表 1. pdb 常用命令

| 命令 | 解释 |

|---|---|

| break 或 b 设置断点 | 设置断点 |

| continue 或 c | 继续执行程序 |

| list 或 l | 查看当前行的代码段 |

| step 或 s | 进入函数 |

| return 或 r | 执行代码直到从当前函数返回 |

| exit 或 q | 中止并退出 |

| next 或 n | 执行下一行 |

| pp | 打印变量的值 |

| help | 帮助 |

pdb 调试有个明显的缺陷就是对于多线程,远程调试等支持得不够好,同时没有较为直观的界面显示,不太适合大型的 python 项目。而在较大的 python 项目中,这些调试需求比较常见,因此需要使用更为高级的调试工具。接下来将介绍 PyCharm IDE 的调试方法 .

描述

hasattr() 函数用于判断对象是否包含对应的属性。

语法

hasattr 语法:

hasattr(object, name)

参数

- object -- 对象。

- name -- 字符串,属性名。

返回值

如果对象有该属性返回 True,否则返回 False。

实例

以下实例展示了 hasattr 的使用方法:

#!/usr/bin/python

# -*- coding: UTF-8 -*-

class Coordinate:

x = 10

y = -5

z = 0

point1 = Coordinate()

print(hasattr(point1, 'x'))

print(hasattr(point1, 'y'))

print(hasattr(point1, 'z'))

print(hasattr(point1, 'no')) # 没有该属性

输出结果如下:

True

True

True

False

numpy.ceil(x, /, out=None, *, where=True, casting='same_kind', order='K', dtype=None, subok=True[, signature, extobj]) = <ufunc 'ceil'>

Return the ceiling of the input, element-wise.

The ceil of the scalar x is the smallest integer i, such that i >= x. It is often denoted as .

Parameters:

x : array_like

Input data.

out : ndarray, None, or tuple of ndarray and None, optional

A location into which the result is stored. If provided, it must have a shape that the inputs broadcast to. If not provided or None, a freshly-allocated array is returned. A tuple (possible only as a keyword argument) must have length equal to the number of outputs.

where : array_like, optional

Values of True indicate to calculate the ufunc at that position, values of False indicate to leave the value in the output alone.

**kwargs

For other keyword-only arguments, see the ufunc docs.

Returns:

y : ndarray or scalar

The ceiling of each element in x, with float dtype.

Examples

>>> a = np.array([-1.7, -1.5, -0.2, 0.2, 1.5, 1.7, 2.0])

>>> np.ceil(a)

array([-1., -1., -0., 1., 2., 2., 2.])

- 采用{}创建

a={"a":1,"b":2}

- 内置dict()

x=dict(a="1",b="2")

x=dict((("a","1"),("b","2")))

x=dict((["a","1"],["b","2"]))

x=dict([("a","1"),("b","2")])

x=dict([("a","1"),["b","2"]])

- fromkeys()方法创建字典

dict.fromkeys(("a","b"),1)

Counter是dict子类,主要是为了对哈希对象进行计数。这是一个集合,其中元素值存储为字典的键,元素的数量存储为字典的值。计数值可以为0或者负值。初始化如下:

>>> c = Counter() # a new, empty counter

>>> c = Counter('gallahad') # a new counter from an iterable

>>> c = Counter({'red': 4, 'blue': 2}) # a new counter from a mapping

>>> c = Counter(cats=4, dogs=8) # a new counter from keyword args

>>> c

Counter({'dogs':8,'cats':4})

>>> c=Counter('aabbbcccc')

>>> c

Counter({'c':4,'b':3,'a':2})

elements

Return an iterator over elements repeating each as many times as its count. Elements are returned in arbitrary order. If an element’s count is less than one, elements() will ignore it.

>>> c = Counter(a=4, b=2, c=0, d=-2)

>>> sorted(c.elements())

['a', 'a', 'a', 'a', 'b', 'b']

most_common([n])

Return a list of the n most common elements and their counts from the most common to the least. If n is omitted or None, most_common() returns all elements in the counter. Elements with equal counts are ordered arbitrarily:

>>> Counter('abracadabra').most_common(3) # doctest: +SKIP

[('a', 5), ('r', 2), ('b', 2)]

subtract([iterable-or-mapping])

原来的元素中减去新传入的元素

Elements are subtracted from an iterable or from another mapping (or counter). Like dict.update() but subtracts counts instead of replacing them. Both inputs and outputs may be zero or negative.

>>> c = Counter(a=4, b=2, c=0, d=-2)

>>> d = Counter(a=1, b=2, c=3, d=4)

>>> c.subtract(d)

>>> c

Counter({'a': 3, 'b': 0, 'c': -3, 'd': -6})

update([iterable-or-mapping])

Elements are counted from an iterable or added-in from another mapping (or counter). Like dict.update() but adds counts instead of replacing them. Also, the iterable is expected to be a sequence of elements, not a sequence of (key, value) pairs.

import collections

obj = collections.Counter(['11','22'])

obj.update(['22','55'])

print(obj)

#输出:Counter({'22': 2, '11': 1, '55': 1})

其他操作

>>> c = Counter(a=3, b=1)

>>> d = Counter(a=1, b=2)

>>> c + d # add two counters together: c[x] + d[x]

Counter({'a': 4, 'b': 3})

>>> c - d # subtract (keeping only positive counts)

Counter({'a': 2})

>>> c & d # intersection: min(c[x], d[x]) # doctest: +SKIP

Counter({'a': 1, 'b': 1})

>>> c | d # union: max(c[x], d[x])

Counter({'a': 3, 'b': 2})

- 概述

os.walk() 方法用于通过在目录树中游走输出在目录中的文件名,向上或者向下。

os.walk() 方法是一个简单易用的文件、目录遍历器,可以帮助我们高效的处理文件、目录方面的事情。

在Unix,Windows中有效。

- 语法

**walk()**方法语法格式如下:

os.walk(top[, topdown=True[, onerror=None[, followlinks=False]]])

参数

- top -- 是你所要遍历的目录的地址, 返回的是一个三元组(root,dirs,files)。

- root 所指的是当前正在遍历的这个文件夹的本身的地址

- dirs 是一个 list ,内容是该文件夹中所有的目录的名字(不包括子目录)

- files 同样是 list , 内容是该文件夹中所有的文件(不包括子目录)

- topdown --可选,为 True,则优先遍历 top 目录,否则优先遍历 top 的子目录(默认为开启)。如果 topdown 参数为 True,walk 会遍历top文件夹,与top 文件夹中每一个子目录。

- onerror -- 可选,需要一个 callable 对象,当 walk 需要异常时,会调用。

- followlinks -- 可选,如果为 True,则会遍历目录下的快捷方式(linux 下是软连接 symbolic link )实际所指的目录(默认关闭),如果为 False,则优先遍历 top 的子目录。

返回值

该方法没有返回值。

-

目录结构如下图所示:

'./'表示‘f:/软件所工作/software/tensorflow_learning’

-

输出x[0]

说明:输出目录树中所有文件夹的路径

for x in os.walk('./'):

print(x[0])

结果如下:

for x in os.walk('./'): ... print(x[0]) ... ./ ./.vscode ./.vscode.ropeproject ./learing_tensorflow_book ./learing_tensorflow_book\chapter5 ./learing_tensorflow_book\chapter5_pycache_ ./learing_tensorflow_book\chapter6 ./learing_tensorflow_book\chapter6\flower_photos ./learing_tensorflow_book\chapter6\flower_photos\flower_photos ./learing_tensorflow_book\chapter6\flower_photos\flower_photos\daisy ./learing_tensorflow_book\chapter6\flower_photos\flower_photos\dandelion ./learing_tensorflow_book\chapter6\flower_photos\flower_photos\roses ./learing_tensorflow_book\chapter6\flower_photos\flower_photos\sunflowers ./learing_tensorflow_book\chapter6\flower_photos\flower_photos\tulips ./tensorflow-tutorial-master ./tensorflow-tutorial-master\Data_sets ./tensorflow-tutorial-master\Data_sets\MNIST_data

未完省略

-

输出x[1]

说明:沿着目录树,输出当前目录下(不包含子目录)所有子文件夹的名称列表

for x in os.walk('./'):

print(x[1])

结果如下:

for x in os.walk('./'): ... print(x[1]) ... ['.vscode', 'learing_tensorflow_book', 'tensorflow-tutorial-master'] ['.ropeproject'] [] ['chapter5', 'chapter6'] ['pycache'] [] ['flower_photos'] ['flower_photos'] ['daisy', 'dandelion', 'roses', 'sunflowers', 'tulips'] [] [] [] [] [] ['Data_sets', 'tensorflow-tutorial-master'] ['MNIST_data'] []

未完省略

-

输出x[2]

说明:沿着目录树,输出当前目录下(不包含子目录)所有文件列表,包括空列表

for x in os.walk('./'): print(x[2])

for x in os.walk('./'): ... print(x[2]) ... ['checkpoint', 'demo_test1.py', 'DQN.py', 'intro_tf.py', 'tensorflow-tutorial-master.zip'] ['launch.json', 'settings.json'] ['config.py'] ['chapter4.py', 'chapter5.py', 'chapter5_4.py', 'chapter5_5.py', 'chapter5_b.py'] ['checkpoint', 'mnist_eval.py', 'mnist_inference.py', 'mnist_train.py', 'model.ckpt-25001.data-00000-of-00001', 'model.ckpt-25001.index', 'model.ckpt-25001.meta', 'model.ckpt-26001.data-00000-of-00001', 'model.ckpt-26001.index', 'model.ckpt-26001.meta', 'model.ckpt-27001.data-00000-of-00001', 'model.ckpt-27001.index', 'model.ckpt-27001.meta', 'model.ckpt-28001.data-00000-of-00001', 'model.ckpt-28001.index', 'model.ckpt-28001.meta', 'model.ckpt-29001.data-00000-of-00001', 'model.ckpt-29001.index', 'model.ckpt-29001.meta'] ['mnist_inference.cpython-36.pyc', 'mnist_train.cpython-36.pyc'] ['flower_photos.tgz', 'mnist_inference.py', 'mnist_train.py'] ['train_flowers.py'] ['LICENSE.txt']

未完省略

功能:extend() 函数用于在列表末尾一次性追加另一个序列中的多个值(用新列表扩展原来的列表)。

extend()方法语法:

list.extend(seq)

#!/usr/bin/python

aList = [123, 'xyz', 'zara', 'abc', 123];

bList = [2009, 'manni'];

aList.extend(bList)

print "Extended List : ", aList ;

以上实例输出结果如下:

Extended List : [123, 'xyz', 'zara', 'abc', 123, 2009, 'manni']

通配符是一些特殊符号,主要有星号(*)和问号(?),用来模糊搜索文件,“*”可以匹配任意个数个符号, “?”可以匹配单个字符。当查找文件夹时,可以使用它来代替一个或多个真正字符;

当不知道真正字符或者需要匹配符合一定条件的多个目标文件时,可以使用通配符代替一个或多个真正的字符。

英文 “globbing”意为统配,python在模块glob中定义了glob()函数,实现了对目录内容进行匹配的功能,glob.glob()函数接受通配模式作为输入,并返回所有匹配的文件名和路径名列表,与os.listdir类似。

glob(pathname, recursive=False) 第一个参数pathname为需要匹配的字符串。(该参数应尽量加上r前缀,以免发生不必要的错误) 第二个参数代表递归调用,与特殊通配符“**”一同使用,默认为False。

该函数返回一个符合条件的路径的字符串列表,如果使用的是Windows系统,路径上的“\”符号会自动加上转义符号变为“\”。

time:2019/01/25

1、split(ary, indices_or_sections, axis=0) :把一个数组从左到右按顺序切分 参数: ary:要切分的数组 indices_or_sections:如果是一个整数,就用该数平均切分,如果是一个数组,为沿轴切分的位置(左开右闭) axis:沿着哪个维度进行切向,默认为0,横向切分。为1时,纵向切分

x = np.arange(9.0) np.split(x, 3) [array([ 0., 1., 2.]), array([ 3., 4., 5.]), array([ 6., 7., 8.])] x = np.arange(8.0) np.split(x, [3, 5, 6, 10]) [array([ 0., 1., 2.]), array([ 3., 4.]), array([ 5.]), array([ 6., 7.]), array([], dtype=float64)]

2、(3,)的用法

m = np.arange(8.0) n = np.split(m, (3,)) print(n)

结果:[array([0., 1., 2.]), array([3., 4., 5., 6., 7.])]

机器学习中的用法解释: #axis=1,代表列,是要把data数据集中的所有数据按第四、五列之间分割为X集和Y集。

x, y = np.split(data, (4,), axis=1

3、实际测试

#!/usr/bin/env python

# _*_ coding: utf-8 _*_

import numpy as np

# Test 1

A = np.arange(12).reshape(3, 4)

print A

# 纵向分割, 分成两部分, 按列分割

print np.split(A, 2, axis = 1)

# 横向分割, 分成三部分, 按行分割

print np.split(A, 3, axis = 0)

# Test 1 result

[[ 0 1 2 3]

[ 4 5 6 7]

[ 8 9 10 11]]

[array([[0, 1],

[4, 5],

[8, 9]]), array([[ 2, 3],

[ 6, 7],

[10, 11]])]

[array([[0, 1, 2, 3]]), array([[4, 5, 6, 7]]), array([[ 8, 9, 10, 11]])]

# Test 2

# 不均等分割

print np.array_split(A, 3, axis = 1)

# Test 2 result

[array([[0, 1],

[4, 5],

[8, 9]]), array([[ 2],

[ 6],

[10]]), array([[ 3],

[ 7],

[11]])]

In [5]:

# Test 3

# 垂直方向分割

print np.vsplit(A, 3)

# 水平方向分割

print np.hsplit(A, 2)

# Test 3 result

[array([[0, 1, 2, 3]]), array([[4, 5, 6, 7]]), array([[ 8, 9, 10, 11]])]

[array([[0, 1],

[4, 5],

[8, 9]]), array([[ 2, 3],

[ 6, 7],

[10, 11]])]

- 更快的访问速度

- 减少内存消耗

正常情况下,当我们定义了一个class,创建了一个class的实例后,我们可以给该实例绑定任何属性和方法,这就是动态语言的灵活性。先定义class:

>>> class Student(object):

... pass

...

然后,尝试给实例绑定一个属性:

>>> s = Student()

>>> s.name = 'Michael' # 动态给实例绑定一个属性

>>> print s.name

Michael

还可以尝试给实例绑定一个方法:

>>> def set_age(self, age): # 定义一个函数作为实例方法

... self.age = age

...

>>> from types import MethodType

>>> s.set_age = MethodType(set_age, s, Student) # 给实例绑定一个方法

>>> s.set_age(25) # 调用实例方法

>>> s.age # 测试结果

25

但是,给一个实例绑定的方法,对另一个实例是不起作用的:

>>> s2 = Student() # 创建新的实例

>>> s2.set_age(25) # 尝试调用方法

Traceback (most recent call last):

File "<stdin>", line 1, in <module>

AttributeError: 'Student' object has no attribute 'set_age'

为了给所有实例都绑定方法,可以给class绑定方法:

>>> def set_score(self, score):

... self.score = score

...

>>> Student.set_score = MethodType(set_score, None, Student)

给class绑定方法后,所有实例均可调用:

>>> s.set_score(100)

>>> s.score

100

>>> s2.set_score(99)

>>> s2.score

99

通常情况下,上面的set_score方法可以直接定义在class中,但动态绑定允许我们在程序运行的过程中动态给class加上功能,这在静态语言中很难实现。

- 使用

__slots__

但是,如果我们想要限制class的属性怎么办?比如,只允许对Student实例添加name和age属性。

为了达到限制的目的,Python允许在定义class的时候,定义一个特殊的__slots__变量,来限制该class能添加的属性:

>>> class Student(object):

... __slots__ = ('name', 'age') # 用tuple定义允许绑定的属性名称

...

然后,我们试试:

>>> s = Student() # 创建新的实例

>>> s.name = 'Michael' # 绑定属性'name'

>>> s.age = 25 # 绑定属性'age'

>>> s.score = 99 # 绑定属性'score'

Traceback (most recent call last):

File "<stdin>", line 1, in <module>